如果你想实时显示模型响应回来的文本,我们可以使用流式响应,Streaming Response。要想使用这种方法的响应,可以在创建这个模型实例的时候,把 streaming 设置成 true。然后需要再设置一个回调处理这种流式响应生成的新的文本。

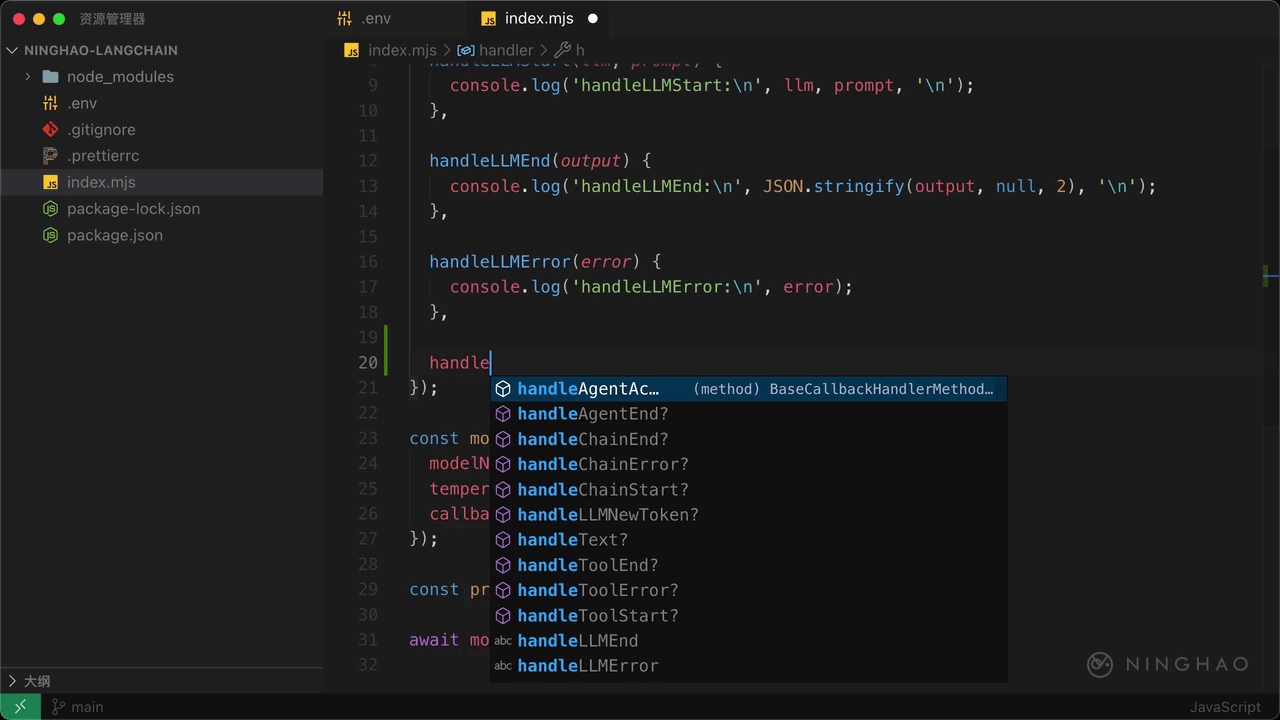

这前我们已经使用 BaseCallbackHandler.fromMethods 这个方法创建了一些处理器,在这个对象里再添加一个新的方法,名字是 handleLLMNewToken,它有一个 token 参数。每次收到模型新生成的内容的时候都会执行这个方法,新生成的内容会交给这个 token 参数。

在这个方法里我们可以用一下 process.stdout.write,把 token 交给这个方法,这样每当有新生成的内容的时候就会实时把它显示在控制台上。

在创建 OpenAI 实例的时候,需要再把 streaming 设置成 true,表示要使用流式响应。

在终端,运行一下应用。你会发现,现在会在终端这里实时显示模型生成的内容。