Hugging Face 是一个 AI 社区,我们可以在 Hugging Face 训练,部署还有使用人工智能模型。Inference 是 HuggingFace 提供的一套接口,通过这套接口可以使用不同类型的人工智能模型提供的服务。

在 LangChain 应用里想要集成使用 HuggingFaceInference 可以先给项目安装一个包,在终端,项目所在目录的下面,执行 npm install 要安装的是 @huggingface/inference 。

然后在 huggingface 网站注册一个账户,登录以后,打开账户设置里面的这个 Access Tokens,在这里可以管理访问令牌,也就是接口密钥,复制一下生成的这个Token。

打开项目的.env 这个文件,在项目的环境变量文件这里,添加一个新的环境变量,名字是 HUGGINGFACEHUB_API_KEY,它的值就是刚才在 huggingface 那里生成的 token。

HuggingFaceInference

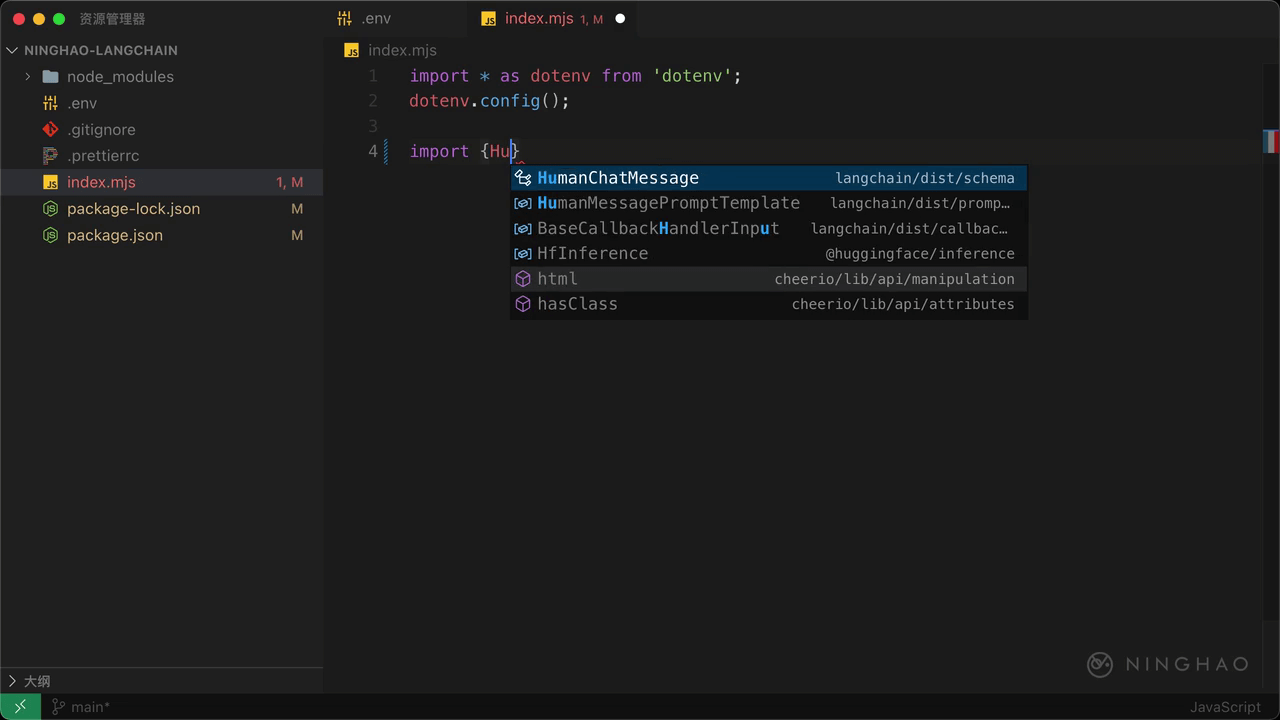

在打开项目里的 index.mjs 这个程序文件,在里面先导入一个 HuggingFaceInference ,来自 langchain/llms/hf 。下面声明一个 model ,新建一个 HuggingFaceInference,提供一个对象,里面可以用 model 设置一下要使用的模型的名字。

打开 huggingface 的网站,在 models 这里可以查看模型。这里我们可以过滤出 Text Generation 类型的模型,然后可以搜索一下 bloom,找到这个 bigscience/bloom-3b 模型的页面,复制一下这个模型的 ID

回到项目,把复制的模型 ID 作为这个 model 属性的值。声明一个 result,等于 await,用一下 model.call 这个方法,提供一个提示文本,比如“从前”。下面可以在控制台上输出这个 result 检查一下。

在终端,项目所在目录的下面,执行 node index.mjs。这回这里输出的文本就是使用 HuggingFace 社区里提供的一个文本生成模型生成的。